太平洋科技 笔记本

【科技实话】AI本地应用,双向奔赴但道阻且长

Dwight

编辑: 韩思同

发布于:2024-03-10 15:01

PConline原创

Dwight

编辑: 韩思同

发布于:2024-03-10 15:01

PConline原创

|

随着OpenAI旗下ChatGPT的爆火,AI相关的应用在这两年来呈井喷式发展,AI人工智能好似前一夜还是《终结者》系列电影中虚构的“天网系统”,而今天它就闯入到了我们的现实世界之中。

不同于概念大于应用的“元宇宙”,AI的发展与应用是我们有目共睹的,AI对话更加智能与准确,国内外公司的LLM频繁推陈出新,Nvidia作为AI计算领域的硬件领导者股价飙升,频繁刷新历史新高,再加上Stable Diffusion、Sora等等,AI目前被普遍认为是将能够改变人们此前生活生产的技术与应用,而并非只停留在概念层面。

去年年底,英特尔与AMD相继发布了加入AI计算单元的酷睿Ultra处理器与8000系锐龙处理器,并且抛出了AI PC的概念,为仅搭载核显的笔记本电脑带来了更高效的AI算力,两家也都非常强调与宣传了本地AI计算、AI应用本地化将会是未来主要发展方向之一。

目前,英特尔的酷睿Ultra处理器、AMD 8000系锐龙移动端处理器均已在终端产品上实际搭载与发售,那么AI PC只是噱头吗?目前有本地AI应用吗?本地AI应用的发展受阻在什么地方?本篇文章就来讨论下这些方面的问题。 ·AI PC是噱头吗? 显然,自英特尔开始着重宣传其搭载了酷睿Ultra处理器的笔记本为“AI PC”后,很多声音都认为AI PC不过是一个噱头罢了。 但在我看来这个事情并非那么绝对,相比于之前无AI计算单元的处理器,有了NPU的加入后,处理器的AI总算力与AI计算的能效比确实有所提升。

这里可以给大家分享一组本地AI应用的实际测试数据,用一台搭载了酷睿Ultra 7 155H处理器机型,在剪映中,将一段1分钟左右的4K视频导入,分别在CPU与NPU上运行AI视频抠像功能,结果二者所用的时间虽然基本相同(运行在CPU上时GPU也会有少量占用参与工作,导致了两者消耗时间相同,如果真的仅有CPU进行工作那么理论上NPU所消耗的时间肯定更短一点),都在35秒左右,但在平均功耗上,运行在NPU上时CPU封装功耗仅为23W左右,而运行在CPU上时CPU封装功耗平均下来高达45W左右,有着近两倍的差距。

导入视频属性

所以,有了专门用于计算的AI处理单元后,AI计算的能效比提升是真实存在的,如果以这个角度来看,AI PC并非噱头;而如果以它是否能够像搭载了独立Nvidia显卡那样快速的运行诸如Stable Diffusion这种对性能要求很高的应用来看,那就另说了,但换句话说,也不可能期望一颗TDP 28W的移动端处理器能够有那样的性能表现。 ·目前有本地AI应用吗? 答案是肯定的,但还不够多,或者说在我们的印象中还不是那么的“AI”。 本地的AI应用其实在之前就很常见了,比如在视频会议时的背景虚化、人眼矫正等功能就是AI功能,这些功能早在ChatGPT爆火前就已经被大面积使用了。 除此之外,像之前介绍到的AI视频抠像,还有比如AI处理图片噪点、AI动作捕捉等也有本地的应用可以实装并使用,但这些应用与我们传统认知的AI应用诸如文生文、文生图尚有差距,相比之下普世的程度也没有那么高。

视频背景更换/虚化 英特尔在AI PC上大力宣传的本地大语言模型目前是可用的,英特尔酷睿Ultra平台的性能可以顺畅运行6B/7B/13B等规模的LLM,但是现在普通个人用户想要在本地部署本地大语言模型的门槛较高,普通电脑用户不具备技术能力在本地进行部署,所以对于大部分人而言,本地的AI对话是处于“可用但无应用可用”的状态。

在酷睿Ultra 7 155H上运行百川7B大模型 Stable Diffusion在社区大神的支援下,目前有“一键部署”的WebUI可用,但就像我之前说的,仅搭载CPU的核显轻薄本也只是能够做到“运行”Stable Diffusion,不能指望其出图的速度如何,有大量AI生图需求的用户还是老老实实买大显存的N卡甚至N卡专业卡会好很多。 所以目前本地AI应用的现状是有但不多,更能普惠用户的AI对话没有一键部署的软件来承载大语言模型,AI生图又对性能的要求较高,核显难以应付。不过相信在不久的将来,越来越多本地AI应用将持续落地,毕竟AI在目前来看是大势所趋,谁不想在这其中分一杯羹呢? ·本地AI发展受阻在哪? 总体来讲,个人认为本地AI应用发展受阻主要在于本地算力、软件适配、商业运作缺乏盈利模式两个方面。 AI想要从云端转移到本地,算力是绕不开的话题,不管是什么类型的AI应用,都需要的是快速响应、低延迟、0等待,那么这就需要更强的本地AI算力,与此同时,如果是“轻薄本”这种对于续航有一定要求的产品形态,在追求更强AI算力的同时,还需要平衡好功耗,降低对内存带宽、显存的高依赖,在不影响续航能力的情况下“无感”的进行AI应用才是之后我认为处理器的主要发展方向之一。目前,Intel与AMD的最新移动端处理器酷睿Ultra与8000系锐龙已经加入了专门的AI计算单元,这个独立的AI计算单元就是用来提升AI算力能效比的,这个方向是对的,但是硬件是有了,想达到预期还需要软件的适配和优化。 所以AI应用本地化,不仅是Intel、AMD这种上游供应商在硬件设计方面需要努力,还需要软件供应商甚至终端产品制造商进行全面的合作和适配。今年是AI PC的元年,Intel和AMD已经迈出了从0到1的最重要一步,后续肯定也会围绕AI在硬件上面进行算力上的加强,随着一代代的升级,我们尚需再给他们一点时间,相信AI方面的性能表现会有阶梯式的提升。

目前,本地AI应用,尤其是普惠型的本地AI应用落地少,除了技术适配需要更多的时间之外,商业运作上缺乏盈利模式也是一个很大的阻力。目前AI相关的软件公司更多的是去开发某一细分领域的专用垂类应用,在当下的环境可能To B可以以更低的成本换来更高的关注度、实装量、资金和收入,例如行者AI推出了专门用于音乐教育的音乐创作系统,教育领域→音乐教育领域,是很细分的一个领域了。

而To C的应用则大不相同,往往需要大量的先期投入,开发费用、营销费用、人力成本等等,这不是小体量公司玩得转的,除了这些外,应用的盈利点对于初创公司来讲也不清晰明朗。 所以,更具普惠型的本地AI应用落地可能要等待到行业更加成熟之后大厂入局,凭借旗下的生态联动、更大的影响力与更多可调配的资源,能够达成从立项到后期盈利的健康链条,可能才会有更易用的应用出现。 ·写在最后 AI从云端转移至本地将会是未来相关公司和厂商的重要着力点。在用户侧,更快的响应、可随时随地调用、无需联网等都是其先天优势;而对于提供商来讲,这将大幅减少服务器的算力和带宽的巨额费用,所带来的成本缩减是极为可观的。可以讲,AI本地应用是用户与厂商的双向奔赴,但这个行业尚属井喷初期,在个人算力紧缺以及商业模式未定的今天,个人用户与厂商之间的双向奔赴还存在不小的阻力。 尽管面临挑战,AI本地应用的前景仍然充满希望,让我们保持期待并耐心等待吧! |

原创栏目

笔记本热点

笔记本视频

IT百科

笔记本热词

网友评论

聚超值•精选

-

- 联想笔记本电脑YOGAPro14s轻薄本 13代酷睿i5 英特尔Evo平台 14.5英寸商务本(i5 32G 1T 3K高刷触控屏)

- 券后省10

-

¥7989.0

¥7999.0

- Apple/苹果 iPad Air(第 5 代)10.9英寸平板电脑 2022年款(256G WLAN版/MM9M3CH/A)粉色

- 券后省700

-

¥5299.0

¥5999.0

- Apple/苹果2020款MacBookAir13.3英寸M1(8+7核) 16G 256G深空灰轻薄笔记本电脑 Z124000CF【定制】

- 券后省800

-

¥8699.0

¥9499.0

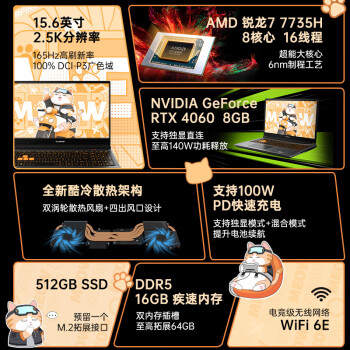

- COLORFIRE MEOW 橘宝 R15 24 七彩虹15.6英寸锐龙R7游戏笔记本 (R7-7735H 16G 512G RTX4060 2.5K 165HZ)

- 券后省300

-

¥5399.0

¥5699.0

- 联想笔记本电脑小新Pro14 AI超能本 高性能标压酷睿Ultra9 14英寸轻薄本 32G 1T 2.8K OLED高刷屏 灰

- 券后省10

-

¥6588.0

¥6999.0

-

- 七彩虹(Colorful)隐星P15 游戏笔记本电脑轻薄高色域高刷电竞本学生PS设计AI将星X15升级款酷睿标压 蓝i5-12450H 16GB 1TB定制 RTX4050电竞独显 15.6英寸

- 券后省300

-

¥4999.0

¥5299.0

- Apple/苹果2023款MacBookAir 15英寸 M2(8+10核)8G 512G深空灰轻薄笔记本电脑MQKQ3CH/A

- 券后省1300

-

¥10699.0

¥11999.0

- 联想笔记本电脑小新Pro16轻薄本 16英寸超能本(高性能标压R7-7735HS 16G 1T 2.5K高刷屏)灰 商务游戏

-

¥5989.0

¥5999.0

- Apple/苹果 iPad Air(第 5 代)10.9英寸平板2022年(256G Cellular版/MM7E3CH/A)深空灰色

- 券后省700

-

¥6499.0

¥7199.0

- 联想笔记本电脑小新Pro16轻薄本 16英寸超能本(高性能标压R7-7735HS 16G 1T 2.5K高刷屏)灰 商务游戏

- 券后省10

-

¥4589.0

¥4599.0

-

- Apple/苹果 iPad mini(第 6 代)8.3英寸平板电脑 2021款(256GB WLAN版/MK7V3CH/A)星光色

- 券后省500

-

¥4699.0

¥5199.0

- 酷比魔方掌玩mini 2024版 全网通通话8.4英寸娱乐游戏办公平板电脑pad安卓mini pro (128GB)标配Googleplay(NFE版)

- 券后省50

-

¥1248.0

¥1298.0

- 科大讯飞(iFLYTEK) AI学习机T10/20个性化精准学儿童家教机学生平板小初高教材英语学习机 【现货速发】讯飞学习机T10【8+256G】

- 券后省600

-

¥6399.0

¥6999.0

- ThinkPad X1 Nano 11代酷睿i5英特尔Evo平台13英寸轻薄笔记本电脑 11代i5 16G 512G 4G流量 0CCD

- 券后省20

-

¥7979.0

¥7999.0

- 【咨询再减】掌阅iReader Ocean3智能电子书阅读器墨水屏电纸书阅览器7英寸小迷你护眼看读书水墨屏pdf阅读器

- 券后省30

-

¥1269.0

¥1663.0

-

- Apple/苹果【教育优惠】iPadmini 8.3英寸平板电脑 2021款(64GB WLAN版/MLWL3CH/A)粉色

- 券后省500

-

¥3099.0

¥3599.0

- AOC一体机电脑全新商务办公家用游戏台式全套整机 23.8英寸酷睿i5+8G+512G 联保三年/内置WIFI.音响/键鼠

- 券后省100

-

¥2599.0

¥2699.0

- Apple/苹果 iPad Pro12.9英寸(第6代)平板电脑2022年款(512GWLAN版/M2芯片/MNXU3CH/A)深空灰色

- 券后省600

-

¥11199.0

¥11799.0

- Apple/苹果【教育优惠】iPad 10.9英寸 2022款(64GB WLAN版/A14芯片/学习办公娱乐/MPQ23CH/A)黄色

- 券后省300

-

¥3099.0

¥3399.0

- Apple/苹果【教育优惠】iPadmini 8.3英寸平板电脑 2021款(256GB WLAN版/MLWR3CH/A)粉色

- 券后省200

-

¥4599.0

¥4799.0

Dwight

Dwight

硬件编年史

硬件编年史