太平洋科技 笔记本

台积电4纳米打造英伟达Blackwell架构GPU,建构迄今最强GB200

小烂毛

整合编辑: 杨玥锴

发布于:2024-03-19 10:04

小烂毛

整合编辑: 杨玥锴

发布于:2024-03-19 10:04

|

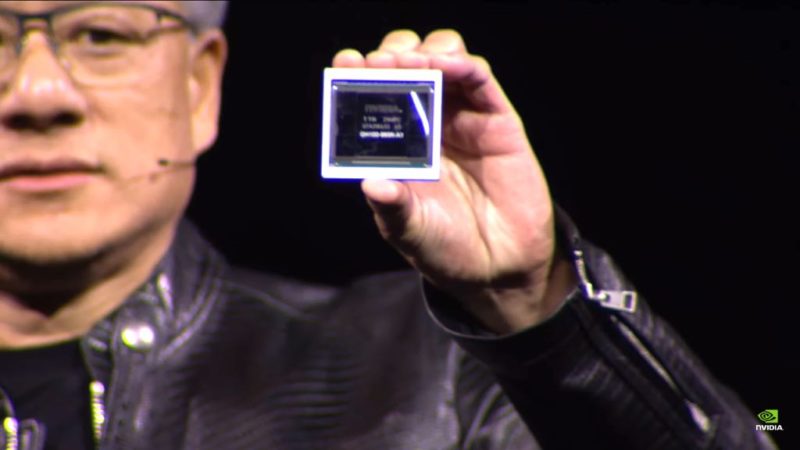

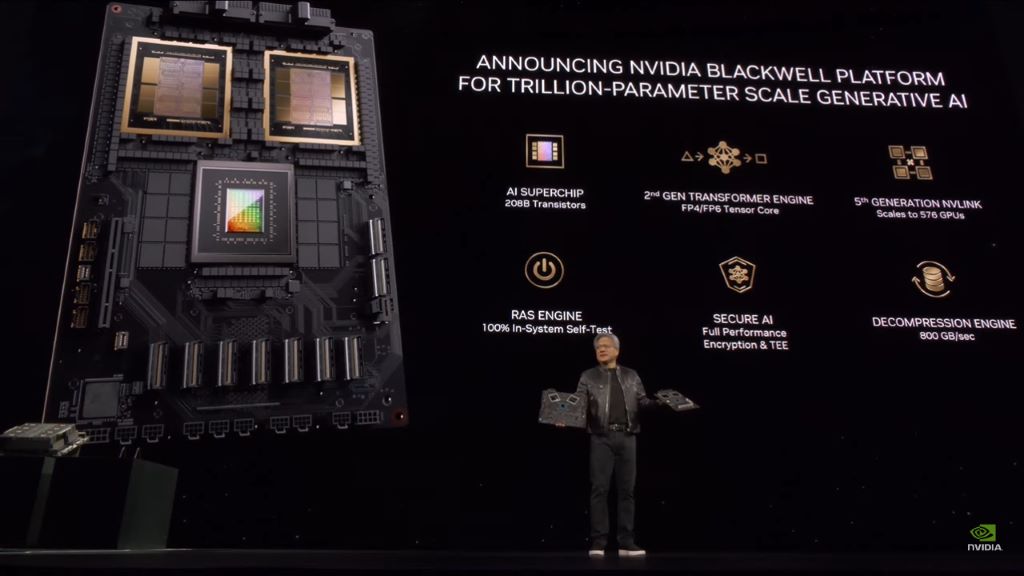

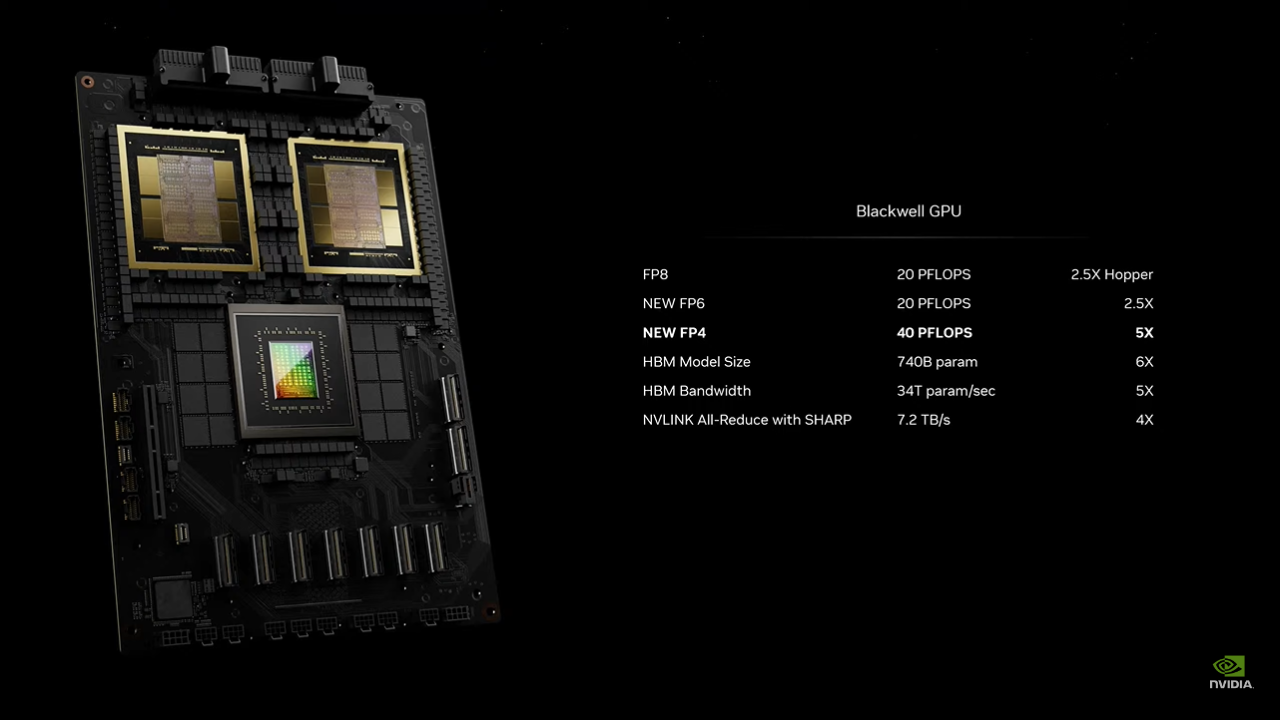

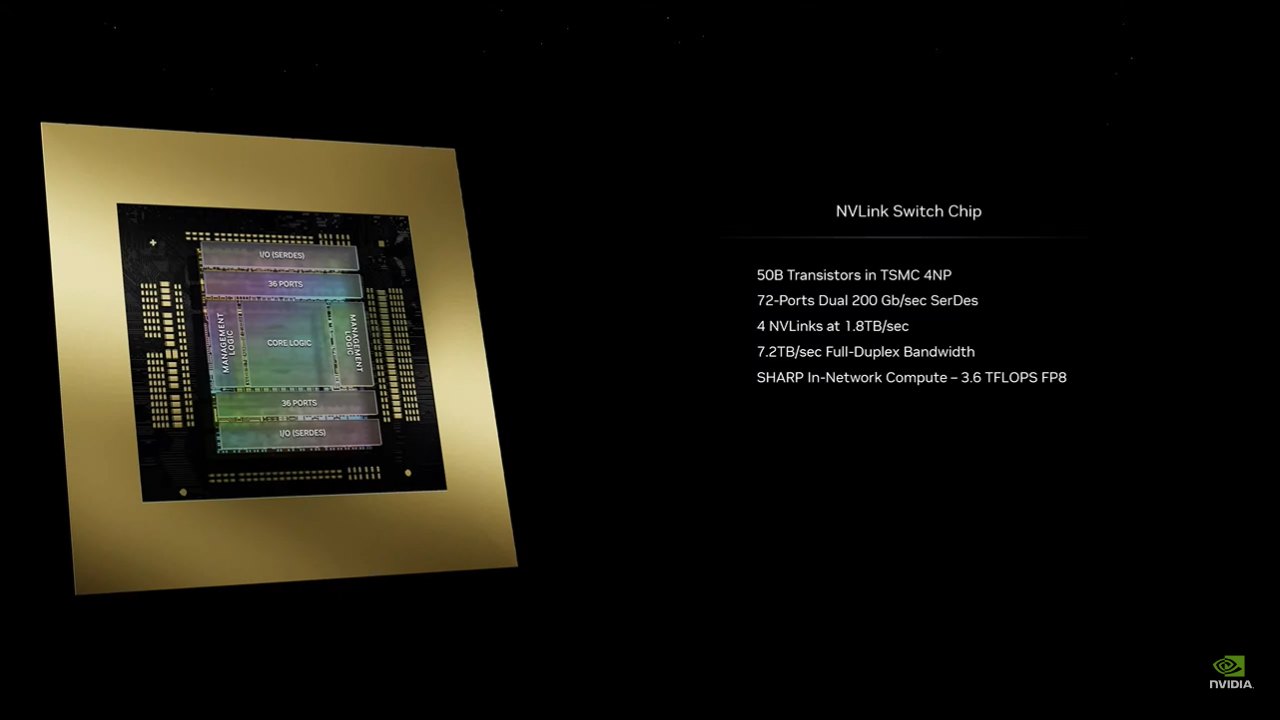

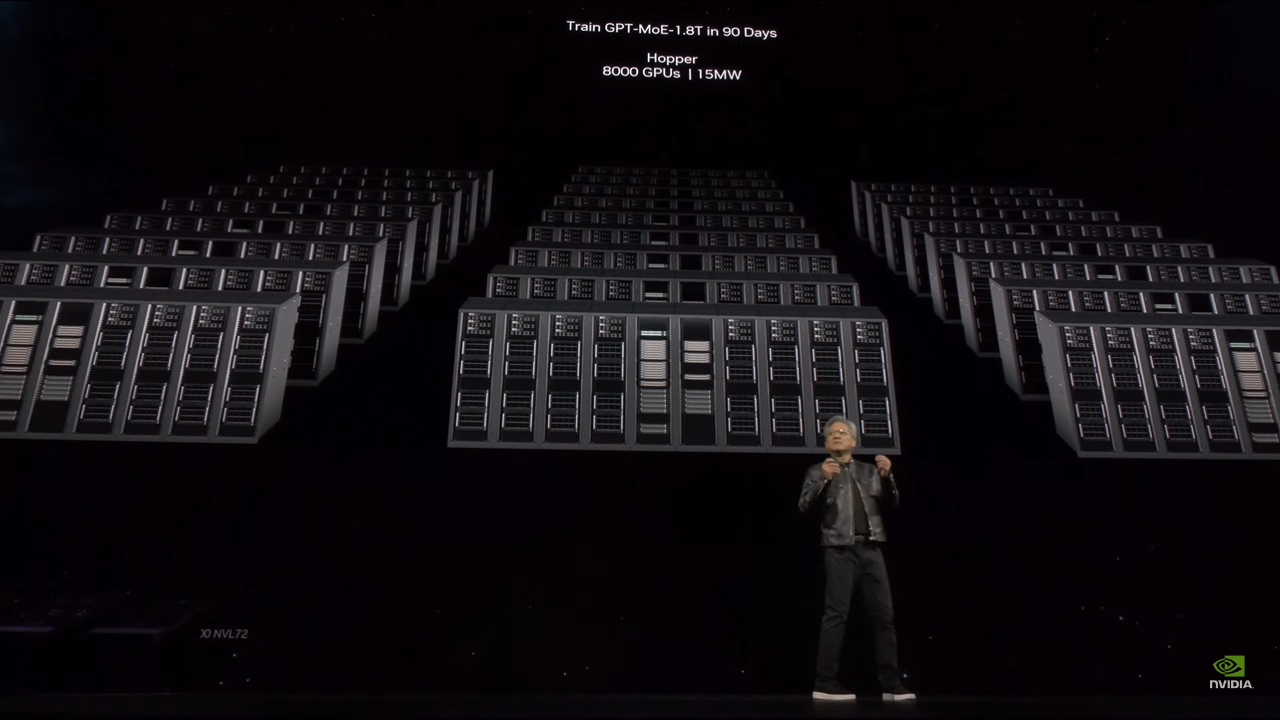

在2024年美国加州圣荷西的GTC大会上,GPU巨头英伟达宣布推出号称目前最强大的AI芯片GB200,并计划于2024年晚期开始正式出货。这款芯片采用了英伟达的最新Blackwell架构,公司创始人兼CEO黄仁勋表示,尽管两年前推出的Hopper架构GPU表现出色,但英伟达仍需要一款更强大的GPU来满足市场需求。 英伟达遵循每两年更新一次GPU架构的策略,以显著提升AI芯片的性能。继2022年发布的基于Hopper架构的H100 AI芯片之后,英伟达继续引领全球AI市场。现在,搭载Blackwell架构的新AI芯片性能将更加强大,尤其是在处理AI任务方面,该架构得名于数学家David Harold Blackwell。 黄仁勋透露,Blackwell架构的AI运算性能在FP8和NEWFP6上可达到20 petaflops,是前一代Hopper架构的8 petaflops性能的2.5倍。在NEWFP4上,性能更是达到了40 petaflops,是Hopper架构的5倍。根据不同设备配置的内存容量和带宽,实际性能可能还会更高。这种额外的处理能力将使人工智能企业能够训练更大、更复杂的模型。 采用台积电4纳米制程技术的Blackwell架构GPU体积庞大,集成了两个独立制造的裸晶(Die),共有2,080亿个晶体管,并通过NVLink 5.0接口连接。英伟达使用每秒10 TB传输速度的NVLink 5.0来连接两块裸晶,官方称该接口为NV-HBI。Blackwell complex的NVLink 5.0接口提供的带宽高达每秒1.8 TB,是前代Hopper架构GPU上NVLink 4.0接口速度的两倍。 黄仁勋进一步指出,新推出的GB200 AI芯片包含两个Blackwell GPU和一个基于Arm架构的Grace CPU。其推理模型性能比H100提升了30倍,同时成本和能耗降低到原来的1/25。 针对有大型需求的客户,英伟达提供完整的服务器产品,如GB200 NVL72服务器,配备了36个CPU和72个Blackwell架构GPU,以及一套完整的水冷散热方案,可实现高达720 petaflops的AI训练性能或1,440 petaflops的推理性能。服务器内部使用的电缆总长度接近2英里,包含5,000条独立电缆。 目前,亚马逊的AWS已计划采购由2万片GB200芯片组成的服务器集群,能够部署拥有27兆参数的模型。除了亚马逊的AWS之外,DELL、Alphabet、Meta、微软、OpenAI、Oracle和TESLA等也成为了Blackwell系列芯片的采用者。 |

原创栏目

笔记本热点

笔记本视频

IT百科

笔记本热词

网友评论

聚超值•精选

-

- HUWI 国行【2024款英特尔可选酷睿】金属笔记本电脑轻薄本大学生上网课设计学习商务办公游戏手提 高配英特尔四核+13代 IPS屏窄边全面屏+抗蓝光 32G运行+1024G超速硬盘

- 券后省130

-

¥2578.0

¥2708.0

- 宏碁掠夺者·擎Neo游戏笔记本电脑 新4060/50系显卡暗影骑士Pro新13代酷睿高压高性能骨灰玩家级 13代高压13500HX丨4050-6G丨高刷满血 【大固态】16G 2000G PCI-e

- 券后省30

-

¥7669.0

¥7699.0

- 英特尔(Intel)NUC7CJYH六月峡谷NUC迷你电脑/迷你主机PC/家用办公客厅HTPC电脑(全新工包中性包装) 准系统(不含内存/硬盘)

- 券后省30

-

¥960.0

¥990.0

- 联想(Lenovo)拯救者刃7000K 2023英特尔酷睿i7游戏电脑主机(13代i7-13700KF RTX4060Ti 8GB显卡 16G 1T SSD)

- 券后省10

-

¥9289.0

¥9299.0

- 铭凡(MINISFORUM) 锐龙7 4800H 八核迷你电脑小主机高性能游戏办公台式机 UM480 XT(R7 4800H) 联发科版 准系统/无内存硬盘系统

- 券后省100

-

¥1199.0

¥1299.0

-

- 华为平板电脑MatePad Pro 11二合一平板高刷120Hz全面屏鸿蒙骁龙学习娱乐办公 【24款】12G+256G WIFI 曜金黑 官方标配+礼品【晒单送礼】

- 券后省50

-

¥4249.0

¥4299.0

- 华硕天选5 15.6英寸高性能电竞游戏本笔记本电脑(锐龙9 R9-8945H 16G 512G RTX4060 2.5K高刷广色域)灰

- 券后省10

-

¥7989.0

¥7999.0

- 极摩客(GMK)K1 6800H AMD R7 高性能游戏办公口袋mini迷你主机台式电脑 准系统(无内存无硬盘系统)

- 券后省800

-

¥1899.0

¥2699.0

- 联想笔记本电脑小新14超薄本 高性能标压酷睿i5 14英寸轻薄本 16G 512G 防眩光屏 灰 办公学生商务

- 券后省10

-

¥3989.0

¥3999.0

- 微软(Microsoft) 【只换不修】Surface Pro 9平板笔记本电脑二合一商务办公轻薄本 Pro 9 i5 8G 128G【亮铂金】 【咨询立减】官方标配(不含键盘领微软鼠标)

- 券后省450

-

¥6538.0

¥6988.0

-

- 雷神(ThundeRobot)911MT黑武士15.6英寸独显轻薄游戏本骨灰玩家级剪辑AI设计师编程移动工作站笔记本电脑变形金刚IP 13代酷睿i7|4060|16G|512原装

- 券后省300

-

¥7699.0

¥7999.0

- ThinkPad E14 英特尔酷睿i5 联想14英寸轻薄便携笔记本电脑(i5 16G 512G 100%sRGB 银)商务办公本

- 券后省10

-

¥4289.0

¥4299.0

- 极摩客【GMK】极摩客K6 迷你主机电脑 7840HS 65W高性能锐龙7 游戏办公设计mini小主机 蓝钛金属色 准系统(无内存/硬盘/系统)

- 券后省300

-

¥2299.0

¥2599.0

- 联想(Lenovo)台式机M4000q 全新小机箱 标压电脑整机商务办公家用 (R5-5600H 8G 512G

- 券后省30

-

¥2869.0

¥2899.0

- 联想联想笔记本电脑小新16 英特尔酷睿标压i5 16英寸轻薄本 16G 512G护眼屏 商务办公学生

- 券后省10

-

¥3989.0

¥3999.0

-

- 掌阅iReader Ocean3 Turbo 7英寸电子书阅读器 墨水屏电纸书电子纸 看书学习便携本 4+64GB

- 券后省10

-

¥1589.0

¥1599.0

- Apple/苹果【教育优惠】 iPad Air 10.9英寸平板电脑 2022款(64G WLAN版/MM9E3CH/A)蓝色

- 券后省700

-

¥3699.0

¥4399.0

- ROG魔霸7 Plus超能版 17.3英寸电竞游戏本笔记本电脑(R9 7945HX液金导热16G1TRTX4090 240HzP3广色域)

- 券后省10

-

¥19989.0

¥19999.0

- Apple/苹果【教育优惠】iPad 10.9英寸 2022款(64GB WLAN版/A14芯片/学习办公娱乐/MPQ23CH/A)黄色

- 券后省300

-

¥3099.0

¥3399.0

- 小度平板学习机G16/K16AI学习平板小学到高中学生平板类纸护眼屏儿童家教机百度文心大模型 G16【4+256G 类纸屏】16重智能护眼

- 券后省50

-

¥1649.0

¥1699.0

小烂毛

小烂毛

硬件编年史

硬件编年史