太平洋科技 笔记本

帮助Siri理解用户提问,苹果提出AI新研究ReALM

小烂毛

整合编辑:杨玥锴

发布于:2024-04-03 10:02

小烂毛

整合编辑:杨玥锴

发布于:2024-04-03 10:02

|

Siri语音助手在理解用户提问时常常需要人们解释半天,因此无法正确回答问题。为了解决这个问题,苹果研究人员开发出了一种新的AI系统——ReALM。ReALM能够理解屏幕画面上的实体,以及对话和背景的上下文关系,有望帮助Siri实现更自然的对话互动。 上周,一篇题为《ReALM:Reference Resolution As Language Modeling》的论文上传至arXiv.org。ReALM利用大型语言模型,将复杂的指代消解任务转换成纯粹的语言模型问题。与现有方法相比,ReALM能够显著提升性能。 苹果研究人员表示:“能够理解上下文,包括参考资料,对语音助理而言相当重要。”为了处理屏幕画面上的参考数据,ReALM的关键做法是解析屏幕画面上的实体及其位置来重建内容,捕捉视觉布局产生文字提示。研究人员证明,这种方法与专门针对指代消解的微调语言模型结合,可在执行解析任务上优于GPT-4表现。 研究人员认为,ReALM优于过去方法,与目前最先进的GPT-4表现大致相同,而且参数相对较少。更重要的是,ReALM在处理特定领域的用户语句方面优于GPT-4,使得ReALM成为可在设备端执行的理想选择。 尽管在迅速发展的AI竞赛中落后于微软、Google、Meta等竞争对手,但苹果在AI研究领域一步步取得重大进展。今年全球开发者大会(Worldwide Developers Conference,WWDC 2024)将是苹果布局AI的重要观察点,市场预期苹果将会对外公开AI计划。 |

原创栏目

笔记本热点

笔记本视频

IT百科

笔记本热词

网友评论

聚超值•精选

-

- 联想(Lenovo)YOGA 27 可旋转27英寸QHD屏一体台式电脑(R7-7840H 32G LPDDR5X 2T SSD可插拔摄像头)银色

- 券后省10

-

¥6989.0

¥6999.0

- Apple/苹果【教育优惠】 iPad Air 10.9英寸平板电脑 2022款(64G WLAN版/MM9E3CH/A)蓝色

- 券后省300

-

¥4099.0

¥4399.0

- Apple/苹果 iPad(第 10 代)10.9英寸平板电脑 2022年款(64GB WLAN版/学习办公娱乐/MPQ13CH/A)蓝色

- 券后省300

-

¥3299.0

¥3599.0

- Apple iPad Pro 12.9英寸平板电脑 2021年款 512GB WLAN版银色原封未激活苹果认证翻新支持全球联保

- 券后省100

-

¥7399.0

¥7499.0

- Apple/苹果 iPad Pro 12.9英寸(第6代)平板电脑 2022年款(512G WLAN版/M2芯片/MNXV3CH/A)银色

- 券后省600

-

¥11199.0

¥11799.0

-

- Apple/苹果 iPad Air(第 5 代)10.9英寸平板电脑 2022年款(64G Cellular版/M1芯片 MM753CH/A)深空灰色

- 券后省400

-

¥5599.0

¥5999.0

- 联想笔记本电脑小新Pro14轻薄本 英特尔Evo 14英寸超能本(12核标压i5 16G 512G 2.8K高刷屏)银 商务办公学生

- 券后省10

-

¥5789.0

¥5799.0

- 攀升 商睿3 酷睿i5办公商用家用台式电脑主机(12代i5-12450H 16G 512G Type-C WiFi6 正版Win11)

- 券后省20

-

¥2079.0

¥2099.0

- 铭凡(MINISFORUM) UM790PRO ZEN4锐龙迷你电脑小主机口袋主机性能游戏办公台式机 UM790Pro(R9 7940HS)新版顶壳 准系统/无内存硬盘系统

- 券后省300

-

¥2999.0

¥3299.0

- Apple/苹果iMac24英寸蓝色4.5K屏八核M1芯片(8核图形处理器)16G256G一体式电脑主机【定制机】Z12W0003D

- 券后省1500

-

¥11499.0

¥12999.0

-

- 科大讯飞学习机C10小学初中高中早教机点读机学生平板电脑英语护眼学习教育平板上网课平板 【现货速发】讯飞学习机C10【4+128G】

- 券后省200

-

¥1799.0

¥1999.0

- 天钡AOOSTAR GEM12迷你主机 锐龙高性能电脑整机 电竞游戏小型口袋便携商用MINI台式机配备OCuLink接口 AMD R9-6900HX【无副屏无指纹】 32G内存1TB Nvme固态硬盘

-

¥3059.0

¥3299.0

- 科大讯飞智能AI学习机X3 5G学生平板家教机小初高全科早教机儿童英语点读机翻译机 讯飞学习机X3 5G【6G+128G】可打电话

- 券后省200

-

¥5799.0

¥5999.0

- 联想小新Pro16 2024全新标压酷睿i9高性能版笔记本电脑IPS全高清屏超轻薄学生设计游戏办公手提 小新16 i5-13500H 16G 1TB 升级 独显级显卡丨金属机身丨小数字键盘

- 券后省300

-

¥4699.0

¥4999.0

- Apple/苹果 iPad(第 10 代)10.9英寸平板电脑 2022年款(256GB WLAN版/学习办公娱乐/MPQ93CH/A)蓝色

- 券后省700

-

¥4099.0

¥4799.0

-

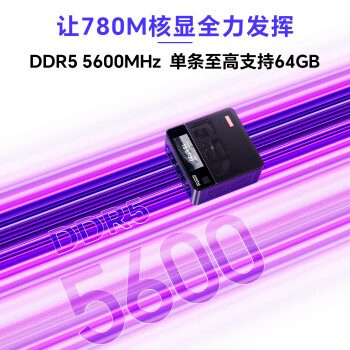

- ThinkPad 联想ThinkBook 16+ 13代英特尔Evo酷睿标压处理器 16英寸轻薄笔记本电脑 2.5K 【升级】i5-13500H 16G 1T 0LCD

- 券后省20

-

¥6179.0

¥6199.0

- 小度添添自由屏 Pro 15.6英寸智能屏K歌音响智能音箱护眼屏平板语音操控AI健身礼物 添添自由屏【128G】

- 券后省5

-

¥2194.0

¥2199.0

- 【2023游戏旗舰本】HP/惠普光影精灵9/暗影精灵英特尔酷睿i7 RTX4060学生办公游戏笔记本电脑惠普官方旗舰店

- 券后省500

-

¥6195.0

¥7895.0

- Apple/苹果 iPad Air(第 5 代)10.9英寸平板2022年(64G 5G版/MM783CH/A)星光色 蜂窝网络

- 券后省400

-

¥5599.0

¥5999.0

- Apple/苹果【教育优惠】 iPad Air 10.9英寸平板电脑 2022款(256G WLAN版/MM9N3CH/A)蓝色

- 券后省400

-

¥5199.0

¥5599.0

推荐

手机

笔记本

影像

硬件

家居

商用

企业

出行

未来

小烂毛

小烂毛

硬件编年史

硬件编年史