太平洋科技 笔记本

四月AI芯片三连发,英伟达:无惧竞争!

小烂毛

编辑:杨玥锴

发布于:2024-04-16 17:49

PConline原创

小烂毛

编辑:杨玥锴

发布于:2024-04-16 17:49

PConline原创

|

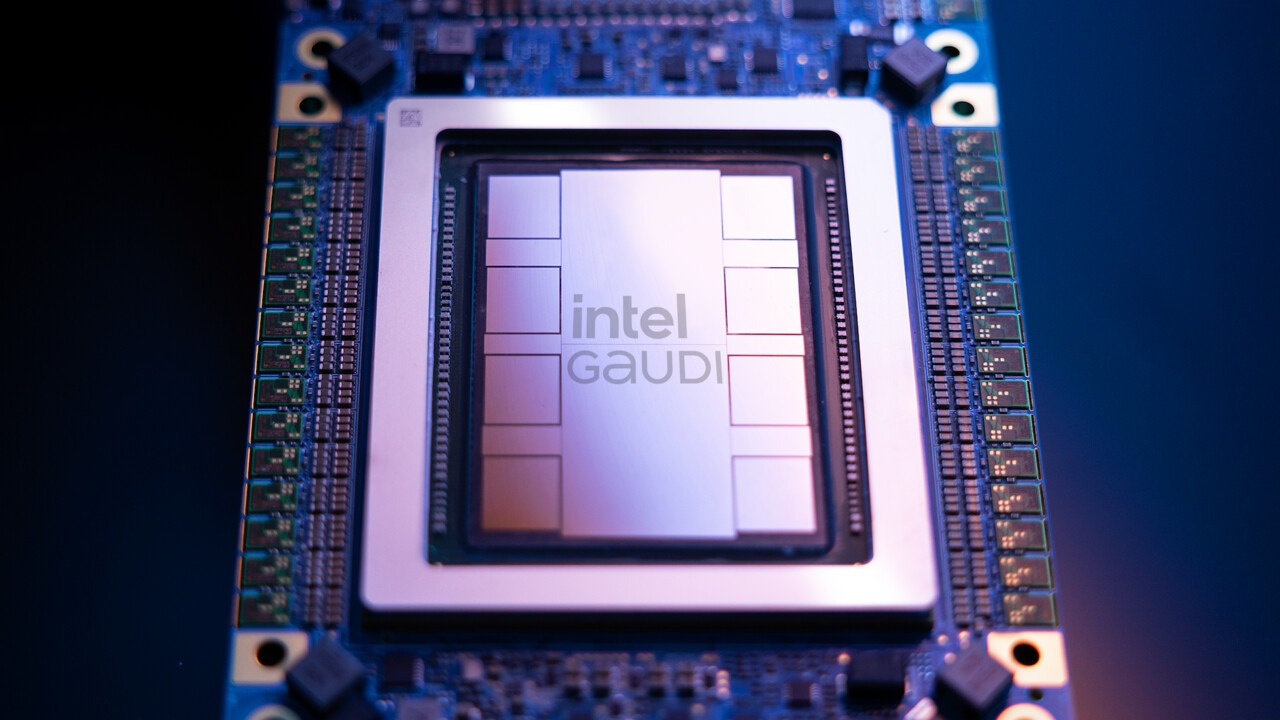

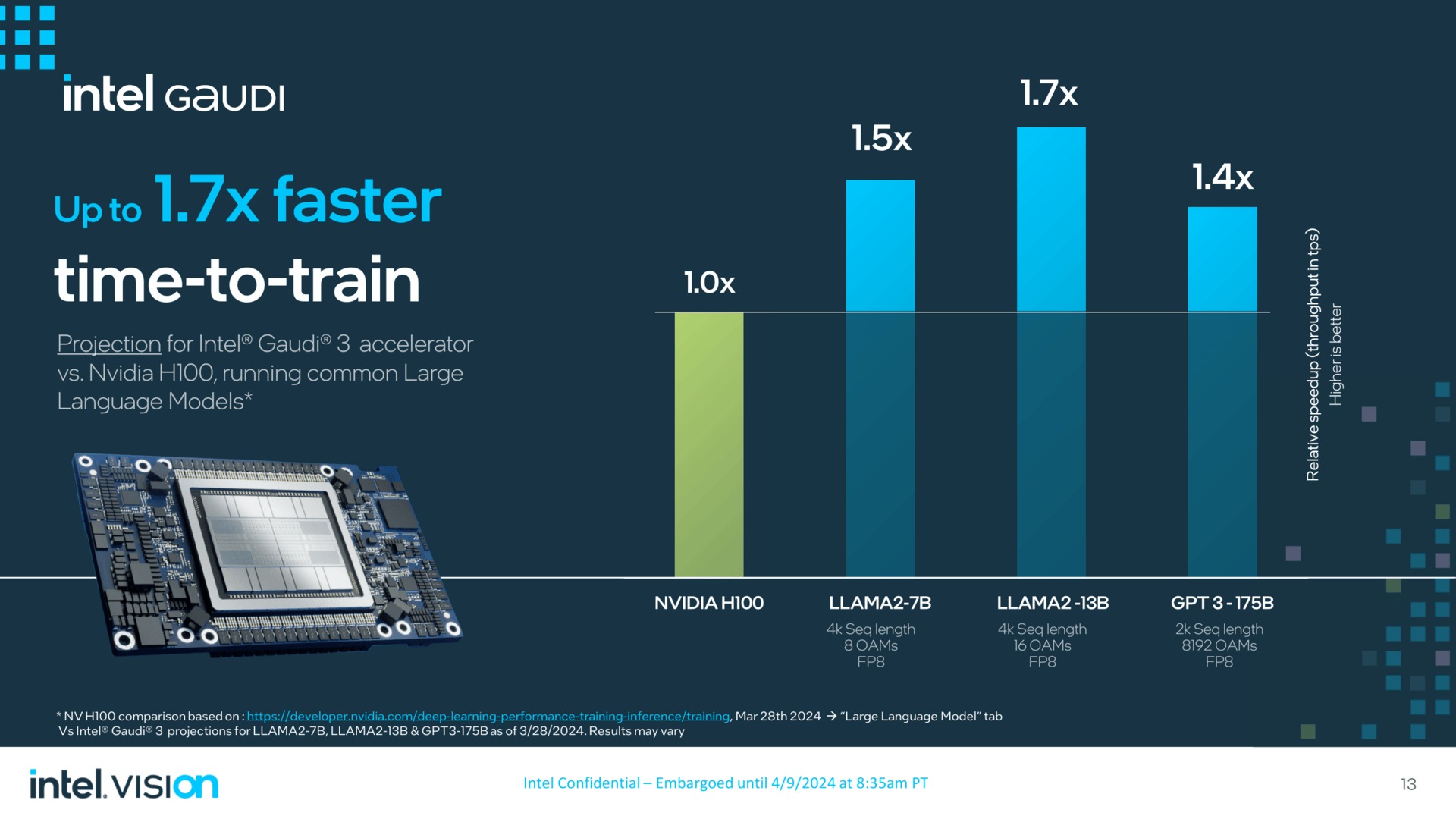

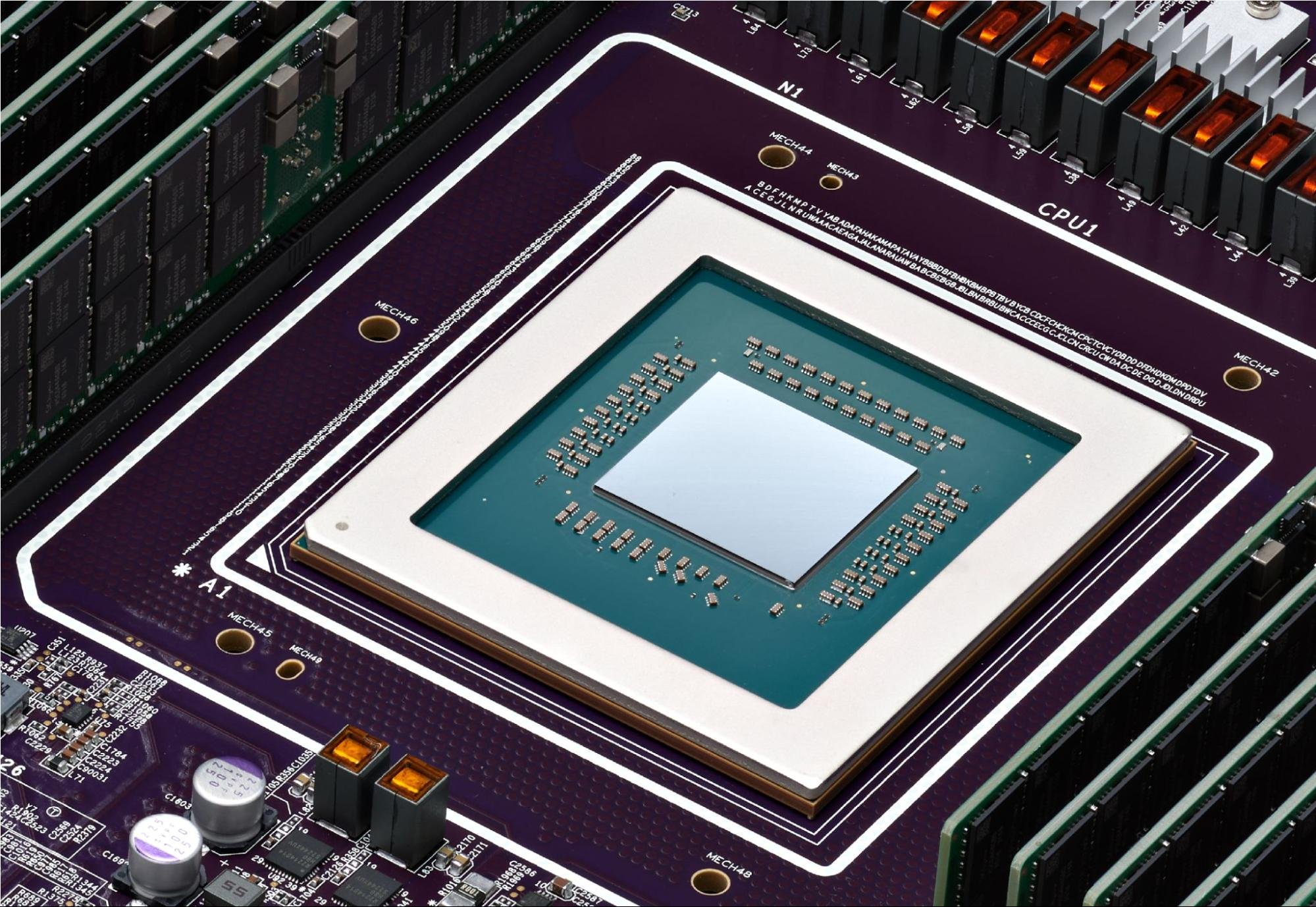

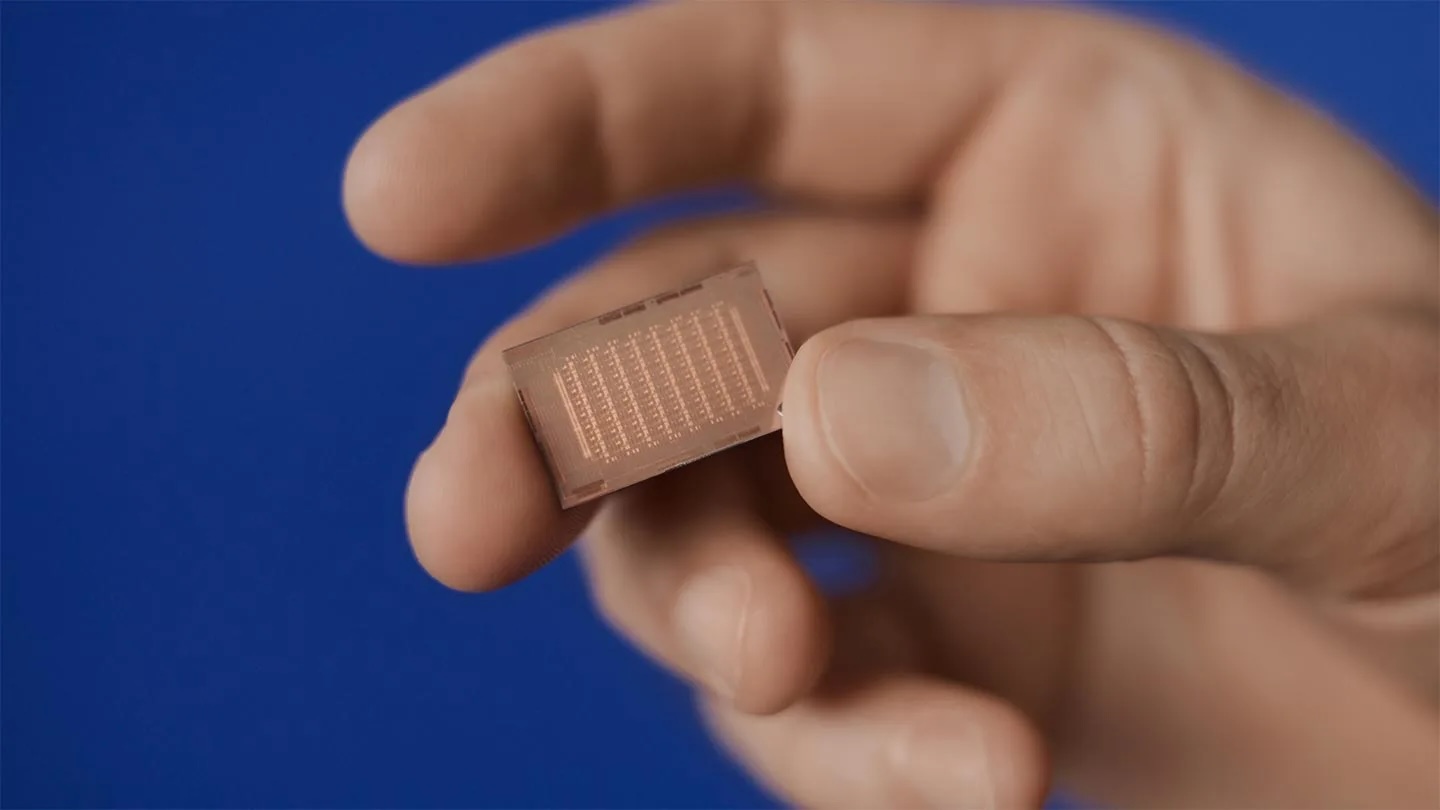

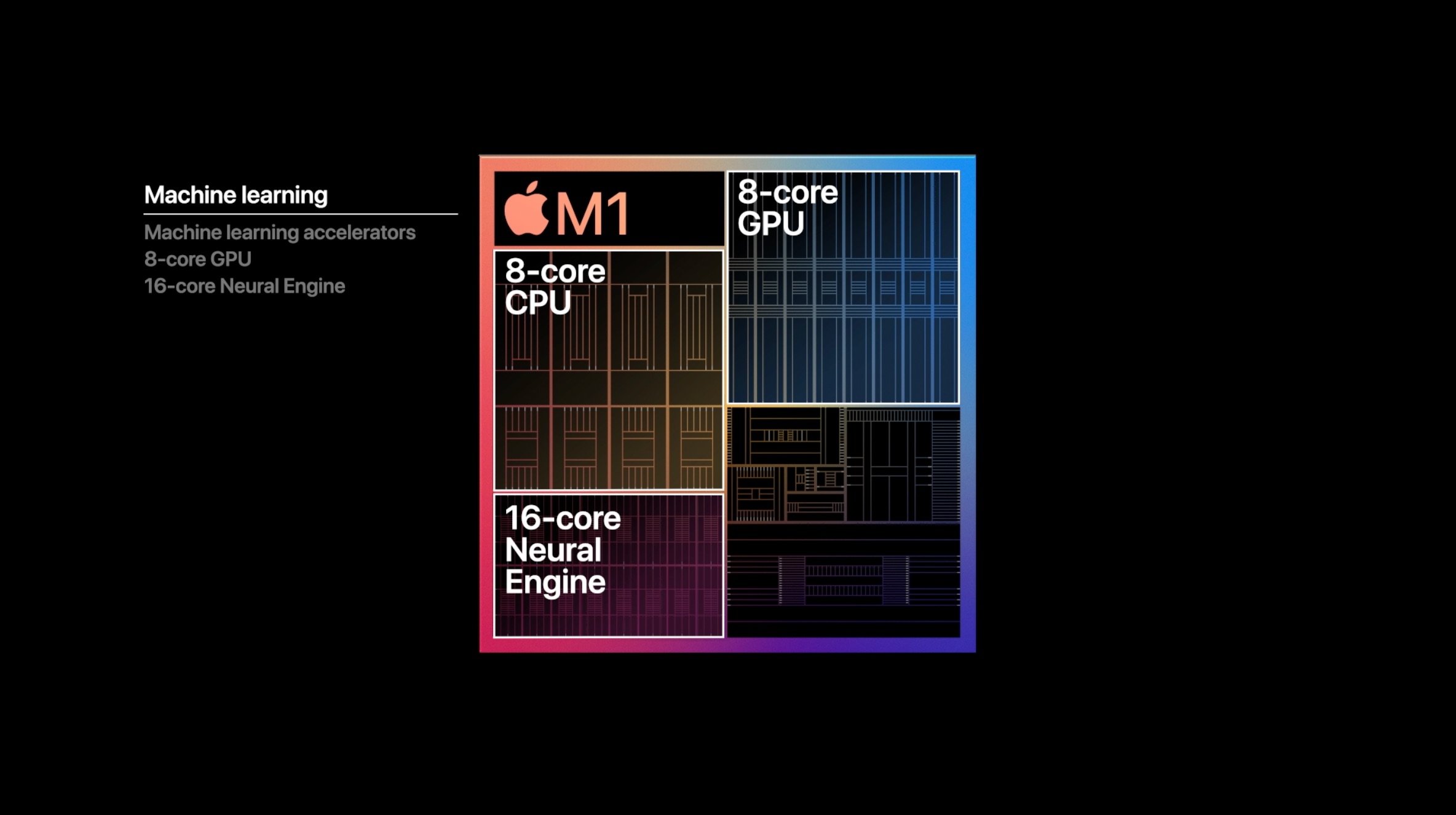

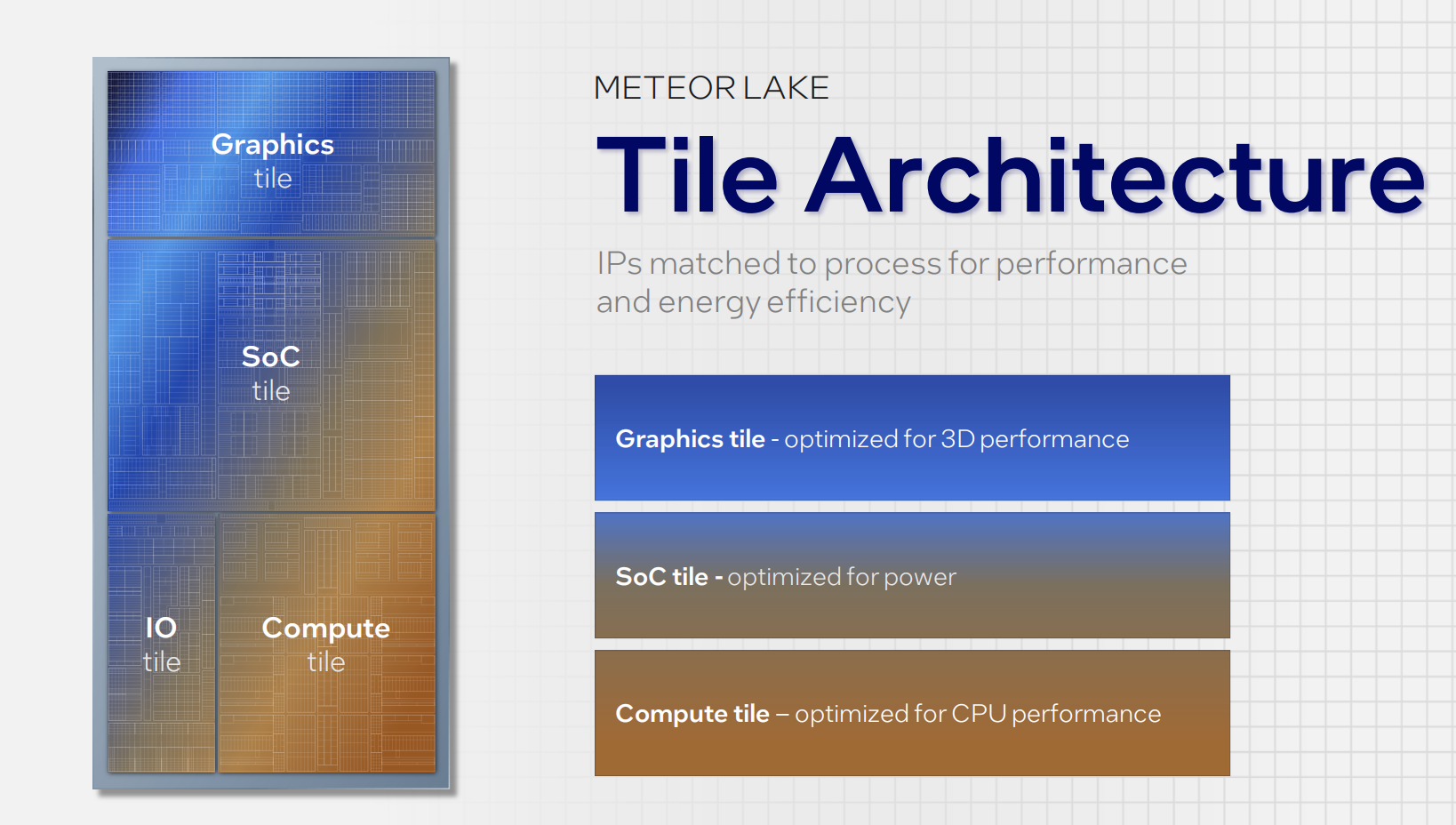

四月我们迎来了AI芯片三连发!4月9日Intel打头阵,在Vision 2024活动中,发布了新一代Gaudi 3 AI芯片。同一天,Cloud Next 2024大会上,Google Cloud首度公开专为数据中心设计的首款Arm架构CPU──Google Axion。隔天,4月11日Meta官方发文,展示新款自研AI芯片MTIA。 ▲ Intel Gaudi 3 在这三款产品中,Intel新一代Gaudi 3与NVIDIA H100展开直接竞争。在AI模型算力中,Gaudi3 AI芯片的模型训练速度、推理速度都更出色,分别提升了40%和50%,平均性能提升达到了50%,能效更是提高了40%。更重要的是,Gaudi3 AI芯片的成本比H100更低,妥妥的性能更强,价格更低。 ▲ Intel Gaudi 3 VS NVIDIA H100 从官方公布的数据来看,Gaudi 3即使是面对NVIDIA的H200 GPU,表现也毫不逊色。在LLAMA-7B以及LLAMA-70B的部分场景与H200基本是伯仲之间,差距基本在10%以内。 ▲ Intel Gaudi 3 VS NVIDIA H200 Intel在Vision 2024上也同步介绍了这款芯片的生产节点,计划在今年第三季度向客户发货Gaudi 3 AI芯片,包括联想、惠普、Dell和Supermicro等OEM厂商都会使用这款新品构建系统。 但是Gaudi 3很难撼动NVIDIA在AI新领域的地位,即便加上AMD的Instinct MI300。 美银分析师Vivek Arya发表研究报告指出,英伟达2024年AI加速器的占有率将超过75%,定制化芯片(如Google TPU、亚马逊Trainium/Inferentia加速器、微软Maia)的占有率为10~15%,而剩余的10~15%才是AMD、英特尔及其他未上市企业的天下。 尽管目前定制化芯片市场占有率不高,但几乎所有服务商都在加速开发各类芯片芯片产品,Google也不例外。 在9日举行的Cloud Next 2024大会上,Google Cloud首度公开专为数据中心设计的首款Arm架构CPU──Google Axion,相较目前最新一代的同等x86架构执行个体,效能最高提升50%、能源效率最高提升60%。 Axion CPU正在支持YouTube广告、Google Earth Engine等多项Google服务。Google Cloud表示,Axion基于开放架构设计,使用Arm技术的客户可以轻松采用,无需进行应用程序重构。Google Cloud客户可在旗下Compute Engine、Kubernetes Engine、Dataproc、Dataflow、Cloud Batch等云服务中使用Axion CPU。Google Cloud计划于今年稍晚时间向客户开放Axion CPU的使用。 ▲ Google Axion 此外,Google Cloud还推出了下一代AI加速器TPU v5p。单个TPU v5p Pod包含8,960个芯片,是上代TPU v4 Pod的2倍以上。TPU v5p主要用于训练规模最大、要求最高的生成式AI模型。Google Cloud不会对外直接销售Axion CPU和TPU v5p芯片,而是提供给企业客户作为云服务使用。这样做不仅可以减少对英特尔、NVIDIA等外部供应商的依赖,还能更好地优化硬件以满足自家业务的特定需求,为客户提供更具竞争力的云计算和AI服务。 相比Google在AI算力方面具有的规模,Meta的资源相对较少。不过,Meta在AI领域的投入也可谓阔绰。此前有报道称,Meta一次性购买了35万枚NVIDIA H100 GPU,每张售价数万美元,这极大地提升了其AI算力水平,为Meta在人工通用智能(AGI)领域的研发提供了强大支撑。 Meta计划将其计算基础设施升级为“相当于近60万张H100的算力”。除购买GPU外,自研是另一条路径。Meta基础设施副总裁Alexis Bjorlin表示,自研硬件能让公司控制整个技术栈,从数据中心设计到训练框架,这种垂直整合是实现AI研究突破的关键。 去年五月Meta官宣了第一代AI推理加速器MTIA v1,近期又发布下一代产品。新款MTIA芯片采用5nm工艺,拥有更多的处理核心,功耗也从25W提升到了90W,时钟频率也从 800MHz提高到了1.35GHz。Meta表示目前已经在16个数据中心使用新款 MTIA 芯片,与MTIA v1相比,整体性能提高了3倍。但Meta表示,这个提升是通过测试两种芯片的 "四个关键模型" 性能表现得出的。 ▲Meta新一代MTIA芯片 据Meta官方介绍,新一代MTIA的设计理念在于寻求计算、内存带宽和内存容量三者之间的理想平衡。这一改进不仅优化了芯片的性能,更使得推理任务的执行变得更为顺畅。 科技大厂自研定制化芯片,一方面是可以和自身需求高度匹配,另一方面也是出于安全和经济性的考虑,拿NVIDIA H100来说,不仅售价不菲,而且还出现了产能的问题,而AI的发展有高度依赖算力支持。所以科技巨头内部开发芯片的运动正在增长。Meta正加入亚马逊AWS、微软和谷歌母公司Alphabet的行列,试图摆脱这种昂贵的依赖。 然而,这并未对行业对NVIDIA AI加速器的巨大需求产生显著影响。在AI热潮下,NVIDIA成为世界第三大科技公司,仅次于微软和苹果公司。其在2024财年的数据中心运营商销售额总计475亿美元,高于前一年的150亿美元。分析师预测,这一数字在2025财年将进一步翻倍,来数年内这一地位可能还会进一步巩固。 AI转变PC处理器升级重点 AI技术的蓬勃发展不仅改变了服务器端芯片的走向,也正在深刻影响个人电脑(PC)处理器的发展。自苹果M系列芯片率先集成神经网络处理单元(NPU)以来,其他厂商也纷纷跟进。AMD从锐龙7000系列笔记本处理器中开始加入NPU。而英特尔则在推出"AI PC"的概念时,明确将NPU作为硬性指标之一。 NPU是专门针对人工智能和机器学习场景进行优化设计的处理器。相比通用的CPU和GPU,NPU在硬件结构上做了针对性优化,专注于高效执行神经网络推理等AI相关计算任务。 ▲苹果M1芯片 过去几十年里,PC处理器的发展一直围绕CPU性能提升为主。但在AI时代,各类AI技术的爆发性增长,迫使芯片厂商不得不在AI能力上下大力气。微软推出的Windows Copilot等AI功能,对PC芯片的AI性能提出了更高要求。 为满足这一需求,AMD计划在即将推出的Strix Point APU上大幅增强NPU性能,甚至牺牲了部分CPU和GPU缓存空间。英特尔在Arrow Lake、Lunar Lake和Panther Lake等新一代芯片中也投入了大量资源,致力于提升NPU算力,分别达到约35 TOPS、105 TOPS和140 TOPS。 ▲英特尔&微软联合定义AIPC 可以看出,AI PC正成为芯片厂商新的竞争焦点。NPU正从辅助性能向核心功能转变,未来可能成为PC处理器升级的重点,取代传统CPU和GPU性能的优先地位。这一趋势反映了AI正深刻改变着PC生态的技术架构。 SoC是大势所趋 NPU的加入也在影响芯片设计制造方式,SoC(System-on-Chip)在手机行业中已经变得非常普遍,现在,这种集成设计的理念也开始渗透到个人电脑芯片的设计中, SoC设计的优势在于可以将CPU、GPU、NPU等各种功能单元集成在一个芯片上,使内存和处理器能够更加紧密地集成,从而提高数据传输速度和整体系统性能。这正如苹果M系列芯片所展现的优势:通过紧密集成内存,可以显著提升内存带宽。 Intel的Core Ultra和AMD的Ryzen 8000系列处理器都采用了SoC设计,充分证明了这一趋势。这些新一代处理器集成了CPU、GPU、NPU等多种功能单元,并且多数与板载内存直接连接,进一步提升了系统性能。 不过,对于桌面PC来说,SoC设计还存在一些局限性。台式机处理器往往需要更强的升级性,而SoC结构不利于后续的硬件升级。因此,Intel和AMD在笔记本芯片上采用了SoC和传统处理器+芯片组的双线并进策略,以兼顾不同市场需求。 |

原创栏目

笔记本热点

笔记本视频

IT百科

笔记本热词

网友评论

聚超值•精选

-

- 小度大屏学习机P20Pro博学版(6+128G)15.6英寸小学到高中学生平板电脑 百度文心大模型 AI精准学朗文家

- 券后省5

-

¥3894.0

¥3899.0

- 小米(MI)RedmiBook Pro 15 2023 锐龙版 3.2K高分屏学生办公轻薄性能本 小米笔记本电脑 R7-7840HS/16G/512G/Office Redmi Book Pro 15

- 券后省160

-

¥4639.0

¥4799.0

- 掌阅iReader Smart Air 8英寸电子书阅读器 墨水屏电纸书电子笔记本智能办公本 300PPI超清显示 幽峻黑

- 券后省10

-

¥1849.0

¥1859.0

- Apple/苹果 iPad Air(第 5 代)10.9英寸平板电脑 2022年款(64G WLAN版/MM9C3CH/A)深空灰色

- 券后省300

-

¥4499.0

¥4799.0

- AMD锐龙R7 8700F/RX6750 GRE/RX7700XT 12G AI处理器直播电脑主机整机2k吃鸡LOL电竞游戏diy组装台式全套装

- 券后省300

-

¥4799.0

¥5099.0

-

- 联想笔记本电脑小新Pro16轻薄本 16英寸超能本(高性能标压R7 16G 512G 2.5K高刷护眼屏)灰 商务办公学生

- 券后省10

-

¥5989.0

¥5999.0

- 七彩虹(Colorful)G-ONEPlus高端电竞一体机i9 3060独显超清大屏一体游戏台式电脑 31.5英寸:i7-12700H/32G1TB升级 RTX3060-6G满血

- 送赠品

-

¥6699.0

¥7299.0

- 天虹TexHoo ZN11 锐龙R7/R5迷你小主机 高性能办公游戏NUC口袋mini台式电脑整机 R5-5500U 准系统(无内存硬盘带WiFi6)

- 券后省10

-

¥889.0

¥899.0

- Apple/苹果2020款MacBookAir13.3英寸M1(8+7核) 8G 256G 银色轻薄笔记本电脑 MGN93CH/A

- 券后省800

-

¥7199.0

¥7999.0

- BOOX文石 Leaf2 阅读礼盒 7英寸电子书阅读器平板 墨水屏电纸书电子纸 便携阅读看书 电子笔记本 白色

- 券后省10

-

¥1289.0

¥1299.0

-

- Apple/苹果 iPad Pro 11英寸平板电脑 2022年款(2TB WLAN版/M2芯片/学习办公娱乐/MNXN3CH/A)银色

- 券后省600

-

¥15499.0

¥16099.0

- 七彩虹隐星P15 15.6英寸40系列显卡 游戏本电竞笔记本电脑学生设计剪辑AI 4050/4060独显直连 i7-12650H+RTX4060 16G/1.5T固态 苍珀蓝

- 券后省300

-

¥5999.0

¥6299.0

- 宏碁(acer)新蜂鸟A24微边框一体机电脑 家用办公台式机电脑 23.8英寸(酷睿13代i3-13100 8G 512GSSD win11)

- 券后省20

-

¥2879.0

¥2899.0

- 极摩客(GMK)K1 6800H AMD R7 高性能游戏办公口袋mini迷你主机台式电脑 16G+512G固态

- 券后省800

-

¥2199.0

¥2999.0

- 联想小新Pro16 2024全新标压酷睿i9高性能版笔记本电脑IPS全高清屏超轻薄学生设计游戏办公手提 小新16 i5-13500H 16G 1TB 升级 独显级显卡丨金属机身丨小数字键盘

- 券后省300

-

¥4699.0

¥4999.0

-

- 微软(Microsoft)Surface Pro 9二合一平板电脑13英寸8商务便携轻薄办公笔记本 Pro 9 i5 8G 128G【亮铂金】 【咨询立减】官方标配【不含键盘领便携鼠标】

- 券后省450

-

¥6538.0

¥6988.0

- 酷比魔方iPlay50 mini2023年新款掌玩8.4英寸全网通安卓通话平板电脑上网课学生 官方标配mini4G+64G

- 券后省20

-

¥1079.0

¥1099.0

- Apple/苹果 iPad Air(第 5 代)10.9英寸平板电脑 2022年款(64G WLAN版/MM9E3CH/A)蓝色

- 券后省400

-

¥4399.0

¥4799.0

- Apple/苹果 iPad Air(第 5 代)10.9英寸平板 2022年(256G 5G版/MMEX3CH/A)紫色 蜂窝网络

- 券后省400

-

¥6799.0

¥7199.0

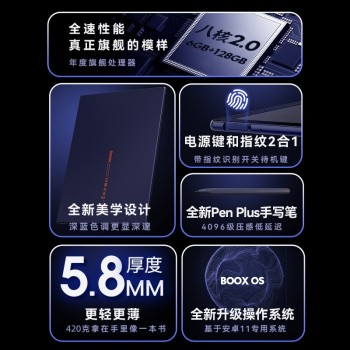

- BOOX文石 Note5+ 智能办公本 10.3英寸电子书阅读器 墨水屏电纸书电子纸套装 阅读电子笔记本6+128GB

- 券后省10

-

¥3970.0

¥3980.0

小烂毛

小烂毛

硬件编年史

硬件编年史