太平洋科技 笔记本

化解"高门槛"迷思,英特尔助力AI PC占据本地大模型部署制高点

小烂毛

编辑:杨玥锴

发布于:2024-04-09 11:43

PConline原创

小烂毛

编辑:杨玥锴

发布于:2024-04-09 11:43

PConline原创

|

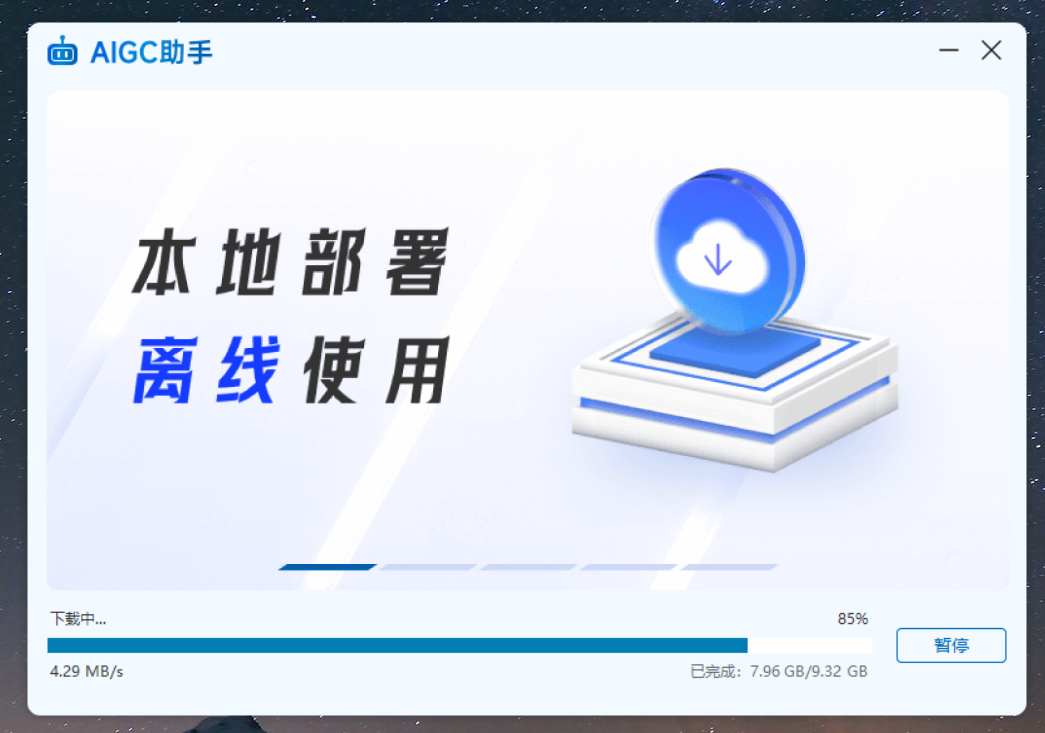

大模型和AIGC技术的发展迅猛,正在重塑众多行业的运作方式。以ChatGPT为代表的大型语言模型已经展现出强大的文本生成、问答和分析能力,而像Stable Diffusion、DALL-E这样的文生图AI也让创作图像资源变得前所未有的高效。 虽然距离AGI还有一定距离,但大模型和AIGC带来的变革已初现端倪。内容创作、客服、办公自动化、游戏、教育等领域都逐渐开始被AI赋能并重塑流程。根据市场调研机构Gartner的预测,到2025年,AI创作工具将贡献30%的新数字化内容。 在AI技术日益普及的今天,AIGC已成为工作生活的重要组成部分。然而,目前主流的AIGC服务主要依赖云端,不仅存在隐私数据安全隐患,而且离线环境下将无法使用。因此,将AI技术部署到每台个人电脑上成为必然趋势。 与云端服务相比,本地部署大型AI模型能最大限度保护个人隐私数据安全,这是端侧AI的关键价值。用户无需再上传敏感数据到云端,大幅降低泄露风险。同时可在离线状态下随时调用强大AI能力,便利性获得极大增强。 作为PC行业的领导者,英特尔提早布局AI领域,并在业界率先提出了AI PC的概念,将AI能力整合到消费级个人电脑中。除了在硬件层面增加AI加速器NPU外,英特尔还在软件生态系统方面进行了广泛的合作,以简化大模型在AI PC上的部署流程,降低普通消费者体验和使用AI功能的门槛。 ▲安装部署过程简单,自动下载模型 目前,在驱动人生平台上架了一款PC端AIGC助手,对于想要体验本地AI大模型的用户来说,无疑是让人兴奋的好消息。这款AIGC助手允许您在AI PC上一键安装!无需具备复杂知识,无需进行繁琐的环境配置,也无需在外网寻找资源。只需从官网下载,像安装其他软件一样双击图标并按照引导操作,即可为您的笔记本轻松添加AI助理。这不仅为用户提供了本地化的对话体验,还确保了数据的安全性。 下载安装完成后的AIGC助手和我们平时使用的软件操作一样,双击桌面图标即可开启,软件打开时会自动加载大语言模型。我们本次体验的AIGC助手,默认下载了Baichuan2-7B-Chat模型。它是百川智能推出的一款开源大语言模型,在多个权威评测榜单均名列前茅。除了开源可免费商用的Baichuan-7B/13B和Baichuan2-7B/13B外,百川智能还推出了六款闭源大模型Baichuan-53B、Baichuan2-53B、Baichuan2-192K、Baichuan2 Turbo、Baichuan-NPC和Baichuan 3。 ▲Baichuan2-7B基准测试表现出色 Baichuan2-7B-Chat是Baichuan2系列模型的一部分,特别针对聊天和对话生成的任务进行了微调。这款模型是基于2.6万亿Tokens的高质量语料训练得到的,并且在多个中英文和多语言的通用领域Benchmark上取得了优异的表现。 AIGC助手使用体验:上手简单,反应迅速,处理高效

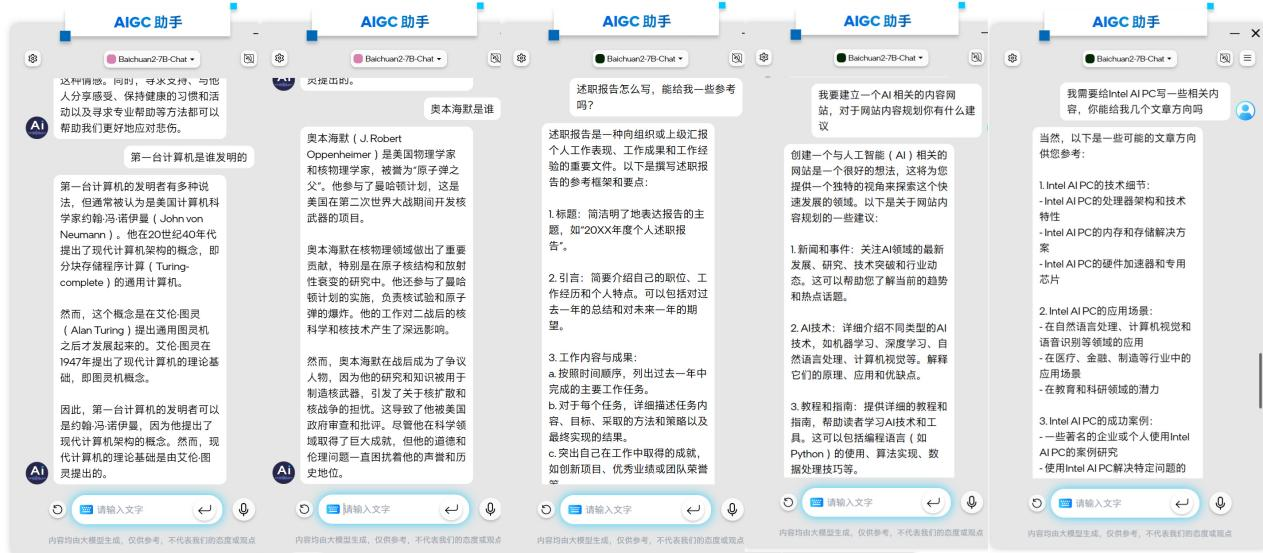

▲无需环境配置,安装后直接打开即可进入对话模式 AIGC助手操作界面非常简单友好,我们完全不需要额外配置就可以直接获取AI提供的一系列服务,包括回答问题、提供建议、语言翻译、娱乐内容推荐、信息搜索以及自然语言交流,可以帮助我们高效完成各项任务。 ▲自然交流可以回答各种问题 自然交流&问答:AIGC助手的使用就像人与人之间的对话一样,我们不需要学习特定的命令或语法,直接使用日常语言就可以与AI进行交流。当我们向AI提出问题时,AI会根据问题的内容进行分析,然后从它的知识库中找到相关的信息,并以易于理解的方式呈现给用户。 ▲可以就同一个问题进行多轮连续的对话 AIGC助手采用的Baichuan2-7B-Chat模型,是百川智能专门用于对话任务的聊天模型,它在理解对话和上下文方面表现出色,具有强大的对话生成能力,使得AIGC助手能够在多轮对话中维持对话的连贯性,并根据之前的对话内容来理解和生成相关的回应。

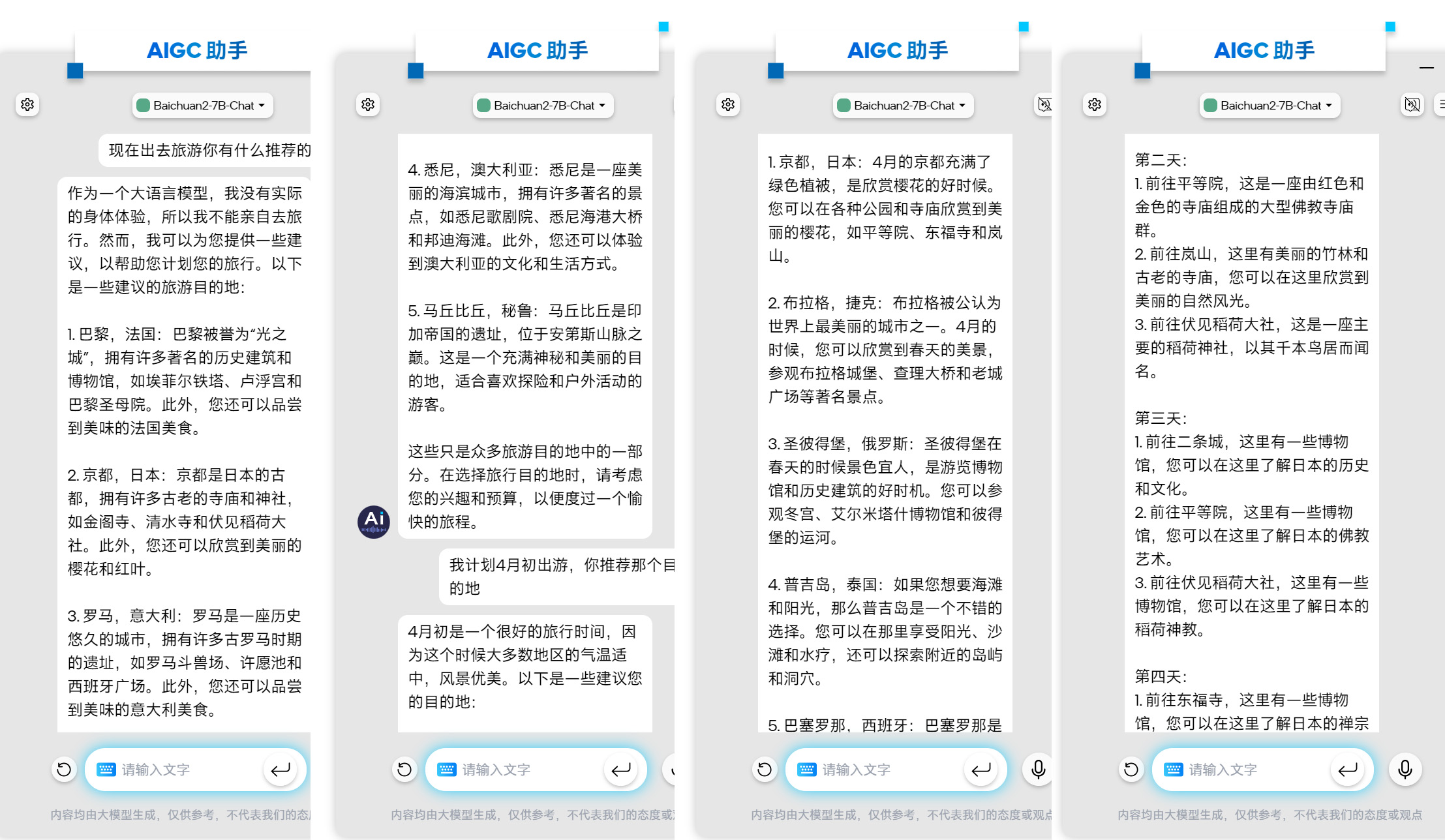

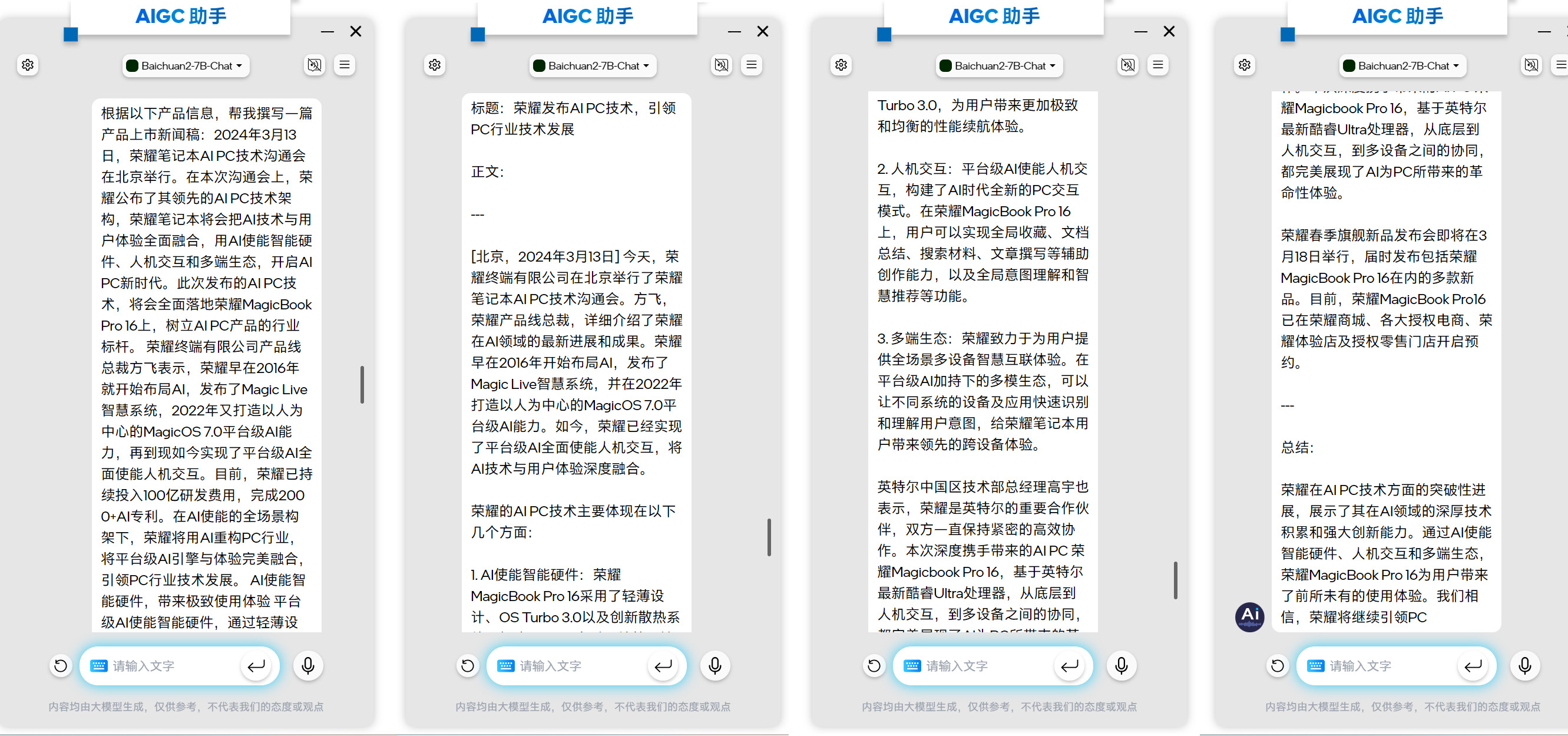

▲长文章翻译 语言翻译:基于Baichuan2-7B-Chat的AIGC助手在中文翻译方面具有出色的性能。得益于深度学习技术和庞大的双语语料库训练,它能够更好地理解句子的整体含义,生成更自然、更符合目标语言习惯的翻译结果。此外,在AIPC上的翻译速度也相当快,为用户提供了高效便捷的语言翻译体验。 ▲根据用户提供的信息撰写文章 文案撰写:在日常工作中,文案撰写是一项常见任务,这些文案通常具有固定结构和模式,如述职报告、工作总结、项目提案和会议记录等。在这些类型的文案撰写中,AI的优势尤为明显,只需将需求提供给AIGC助手,就能快速获得相应文案作为参考。 AI PC:让更多形态的个人计算设备具备本地AI能力 AIGC助手的高效性能和强大功能原本需要依赖高性能独立显卡,但现在得益于英特尔® 酷睿™ Ultra处理器集成的CPU、GPU和NPU三大引擎的强大算力,以及百川智能针对该处理器的专门优化,即便是集成显卡笔记本电脑也能快速高效的本地运行大型AI模型。这种优化意味着不仅台式机,各种形态的便携式设备,如轻薄本、二合一设备,NUC迷你主机,甚至是更多形态的便携式移动终端设备,都能够实现在本地部署大模型。

▲搭载英特尔® 酷睿™ Ultra处理器的游戏掌机也可本地部署AIGC 我们在多设备上测试表明,AIGC助手在各式硬件上均展现出卓越的运行效率,无论是标准笔记本还是低功耗的游戏掌机。这一出色的本地AI体验得益于英特尔® 酷睿™ Ultra处理器搭载的英特尔锐炫™ 显卡提供的强劲计算力,以及英特尔IPEX-LLM团队与百川团队对大模型推理过程的深度优化。 IPEX-LLM是英特尔开源的大语言模型加速库,能够通过全面的低比特模式(INT2/INT4/FP4/NF4/INT8/FP8)和混合精度支持、大语言模型推理过程的全栈优化、高等级的内存管理、友好的开发接和与大语言模型生态链(包括 Hugging Face, 魔搭, vLLM, bitsandbytes, Text-Generation-WebUI, FastChat, LangChain, LlamaIndex, AutoGen, 等)的无缝结合,助力 AI 开发者和研究者在英特尔® 平台上加速优化大语言模型,提升大语言模型的使用体验。 在AIGC助手的合作中,英特尔和百川团队通过创新的高级优化,在提升推理速度的同时,还能够实现高效的计算缓存管理和KV-缓存优化,并针对长序列推理进行了改进,有效降低了显存消耗。 值得一提的是,如果不满足于只在PC上使用AIGC助手,有开发兴趣的用户只需三个简单步骤,即可利用IPEX-LLM实现模型的加速推理,在英特尔® 酷睿™ Ultra处理器上构建自己的AIGC应用,轻松打造个性化的AI解决方案(以发布在魔搭社区的百川7B模型为例)。

毫无疑问,英特尔在推动AI PC进入日常生活和工作领域的进程中,发挥了举足轻重的作用。正是由于英特尔在硬件设计和制造方面的卓越能力,以及对AI技术的持续投入和创新,才使得如此强大的AI功能得以在众多个人设备上实现。英特尔不仅在技术上引领了AI的发展,也在实际应用中推动了AI的普及。 写在最后: 作为PC行业的绝对领导者,英特尔在过去四十年里持续推动着整个PC产业的发展,并多次引领PC产品实现技术跃迁。在20年前,英特尔推出"迅驰"技术,极大提升了笔记本电脑的无线网络体验,确保了无处不在的网络连接,开启了移动办公的新纪元。再向前迈进10年,"超极本"概念的推出再次颠覆了市场,将笔记本的便携性和多功能体验推向了新的高度。 如今,人工智能时代已经到来,AI无疑将深刻改变人类的生产生活方式。作为不可或缺的个人计算设备,PC自然也需要被赋予AI能力以满足未来需求。英特尔远见卓识地提出了"AI PC"的概念,将AI能力植入个人电脑中,从而推动PC产品实现又一次飞跃式的进化,开启全新的智能计算时代。 |

原创栏目

笔记本热点

笔记本视频

IT百科

笔记本热词

网友评论

聚超值•精选

-

- Apple/苹果2023款MacBookAir 15英寸 M2(8+10核)8G 256G星光色轻薄笔记本电脑MQKU3CH/A

- 券后省1300

-

¥9199.0

¥10499.0

- 火影众颜U6/锐龙7/16英寸/2.5K/120Hz高性能轻薄商务笔记本电脑 众颜U6:R5-6600H/16G/512G/2K

- 券后省300

-

¥2899.0

¥3199.0

- 机械革命(MECHREVO)翼龙15 Pro 15.3英寸游戏电竞AIPC轻薄游戏笔记本电脑(R7-8845H 24G 1T RTX4060 2.5K 暮石灰)

-

¥6999.0

¥7699.0

- Apple/苹果 iPad mini(第 6 代)8.3英寸平板电脑 2021款(64GB WLAN版/MK7P3CH/A)星光色

- 券后省200

-

¥3799.0

¥3999.0

- 微软(Microsoft) Surface Laptop Go 3/2/1 商务办公轻薄便携笔记本电脑12.4英寸全面触控屏 【Lp Go2】 i5 8G 128G【仙茶绿】 官方标配【领微软鼠标】

- 券后省100

-

¥4288.0

¥4388.0

-

- iru酷睿i7+独显 15.6英寸13代高配金属笔记本电脑国行轻薄本商务办公学生网课超薄便携性能游戏本手提 指纹解锁 酷睿i7-1165G7+MX450独显 32G内存/1024G固态硬盘

- 券后省400

-

¥4098.8

¥4498.8

- Apple/苹果2022款MacBookAir【教育优惠】13.6英寸M2(8+8核)8G256G星光色轻薄笔记本电脑MLY13CH/A

- 券后省1000

-

¥7199.0

¥8199.0

- 极摩客【GMK】极摩客K6 迷你主机电脑 7840HS 65W高性能锐龙7 游戏办公设计mini小主机 蓝钛金属色 准系统(无内存/硬盘/系统)

- 券后省300

-

¥2299.0

¥2599.0

- ThinkPad 联想 S2 13.3英寸商务办公轻薄笔记本电脑(i7-1255U 16G 512G win11)黑 商务办公学生本

- 券后省10

-

¥6289.0

¥6299.0

- ThinkPad 联想ThinkBook14 12代英特尔酷睿 商务轻薄学生笔记本电脑 14英寸:i5-1240P 512G 9ACD 预装win11

- 券后省20

-

¥3739.0

¥3759.0

-

- 联想(Lenovo)YOGA 27 可旋转27英寸QHD屏一体台式电脑(R7-7840H 32G LPDDR5X 2T SSD可插拔摄像头)银色

- 券后省10

-

¥6989.0

¥6999.0

- 天钡AOOSTAR GEM12迷你主机 锐龙高性能电脑整机 电竞游戏小型口袋便携商用MINI台式机配备OCuLink接口 AMD R7-7840HS【无副屏无指纹】 准系统【无内存无硬盘】

- 券后省200

-

¥2399.0

¥2599.0

- Apple苹果 iPadmini6 第六代 8.3英寸平板电脑 2021款(256GB WLAN版/A15芯片/全面屏/触控ID) 星光色

- 券后省100

-

¥4599.0

¥4699.0

- 神舟(HASEE) MINI PC 酷睿I5 商用办公迷你台式电脑主机 单主机 八核I5-12450H+8G内存+512G固态

- 券后省300

-

¥1699.0

¥1999.0

- 联想(Lenovo)YOGA 27 2023可旋转27英寸QHD屏一体台式电脑(R7-7840H 16G LPDDR5X 1T SSD )银色

- 券后省10

-

¥6289.0

¥6299.0

-

- 科大讯飞学习机C10小学初中高中早教机点读机学生平板电脑英语护眼学习教育平板上网课平板 【现货速发】讯飞学习机C10【4+128G】

- 券后省200

-

¥1799.0

¥1999.0

- Apple/苹果2023款Mac mini迷你主机【教育优惠】M2 Pro(10+16核)16G 512G 台式电脑主机MNH73CH/A

- 券后省300

-

¥8899.0

¥9199.0

- 攀升暴风龙M3 mini电脑 7840HS 高性能AMD锐龙7 游戏商务办公设计台式机迷你电脑主机 R7-7840HS准系统(无内存硬盘系统)

- 券后省200

-

¥2699.0

¥2899.0

- 七彩虹隐星P15 15.6英寸40系列显卡 游戏本电竞笔记本电脑学生设计剪辑AI 4050/4060独显直连 i7-12650H+RTX4060 16G/1.5T固态 苍珀蓝

- 券后省300

-

¥5999.0

¥6299.0

- Apple/苹果【教育优惠】iPad Pro 12.9英寸 2022年款(128G WLAN版/M2芯片/MNXP3CH/A)深空灰色

- 券后省600

-

¥7899.0

¥8499.0

小烂毛

小烂毛

硬件编年史

硬件编年史